أبرز مخاطر الذكاء الاصطناعي

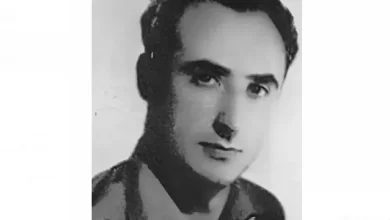

بعد 10 سنوات في خدمة غوغل استقال رائد الذكاء الاصطناعي جيفري هينتون الاثنين الماضي من العملاق الأميركي، موضحا في مقابلة مع صحيفة نيويورك تايمز الأميركية أنه غادر للتحدث بحرية عن الذكاء الاصطناعي التوليدي، وعن 5 مخاطر أساسية للذكاء الاصطناعي.

أدت المنافسة بين عمالقة التكنولوجيا الكبرى إلى تقدم لا يمكن لأحد أن يتخيله، وفقا لجيفري هينتون، فقد تجاوزت السرعة التي يحدث بها التقدم توقعات العلماء و”لم يؤمن سوى عدد قليل من الناس بفكرة أن هذه التكنولوجيا يمكن أن تصبح في الواقع أكثر ذكاء من البشر.. وكنت شخصيا أعتقد أن ذلك لن يحدث إلا في غضون 30 إلى 50 سنة أو ربما أكثر، وبالطبع، لم أعد الآن أعتقد ذلك”.

حتى العام الماضي، لم يكن يعتبر هذا التقدم خطيرا، لكن رأيه تغير عندما طورت غوغل و”أوبن إيه آي” OpenAI أنظمة عصبية قادرة على معالجة كميات كبيرة جدا من البيانات، التي يمكن أن تجعل هذه الأنظمة أكثر كفاءة من الدماغ البشري، وبالتالي فهي خطيرة للغاية.

تقليل فرص الوظائف في كل المجالات

من وجهة نظر اقتصادية، يخشى الأب الروحي للذكاء الاصطناعي من أن هذه التكنولوجيا يمكن أن تعطل سوق العمل بشكل كبير، حيث يقول: “الذكاء الاصطناعي يقضي على العمل الشاق”، مضيفا أنه “يمكن أن يقضي على ما هو أكثر من ذلك بكثير”، مما يؤثر على المترجمين والمساعدين الشخصيين على وجه الخصوص. فالقضاء على فرص العمل لن يسلم منها حتى الأكثر “ذكاء”، حتى وإن اعتقد بعضهم أنهم في مأمن من ذلك.

تهديد “الروبوتات القاتلة”

يرى هذا الخبير أن التقدم التكنولوجي سريع للغاية، مقارنة بالوسائل المتاحة لدينا لتنظيم استخدام الذكاء الاصطناعي، ويعلق على ذلك قائلا: “لا أعتقد أنه يجب علينا الإسراع في ذلك حتى نفهم ما إذا كان بإمكاننا التحكم فيه”، فما يخشاه هذا الخبير هو أن تصبح الإصدارات المستقبلية “تهديدات للبشرية”.

ووفقا لهينتون، ستكون أنظمة الذكاء الاصطناعي المستقبلية قادرة على تطوير سلوكيات غير متوقعة بعد تحليل كمية كبيرة من البيانات، وقد أصبح هذا ممكنا، لأن أنظمة الذكاء الاصطناعي تولد الكود الخاص بها وتوجهه، مما قد يحولها إلى “أسلحة مستقلة” و”روبوتات قاتلة”، رغم أن العديد من اء يقللون من شأن هذا التهديد.

الذكاء الاصطناعي في أيدي جهات خبيثة

ووفقا له، فإن التهديد يأتي أيضا من إساءة استخدام الذكاء الاصطناعي من قبل الجهات الفاعلة الخطرة. وهو قلق من أنه “من الصعب معرفة كيفية منع الجهات السيئة من استخدامه لأغراض شريرة”. ويعارض هينتون بشكل خاص استخدام الذكاء الاصطناعي في المجال العسكري، وهو يخشى أساسا من تطوير البشر “للجنود الآليين”.

وقد كان جيفري هينتون قرر في ثمانينيات القرن الماضي ترك جامعة “كارنيغي ميلون” في الولايات المتحدة، لأن أبحاثه هناك تم تمويلها من قبل البنتاغون.

“مولد تفاهات”

وأخيرا، يحذر جيفري هينتون من المعلومات المضللة المرتبطة بالذكاء الاصطناعي، ويبرز أن هذا الاندفاع العلمي وما يصاحبه من استخدام مكثف للذكاء الاصطناعي سيجعل من المستحيل تقريبا تمييز “ما هو صحيح مما هو كاذب”، حتى أن العالم يتحدث عن “مولد تفاهات”، وهو تعبير يشير إلى قدرة الذكاء الاصطناعي على إنتاج عبارات مقنعة تبدو معقولة دون أن تكون صحيحة.

إذن ما الحل؟ يؤيد خبير الشبكة العصبية تعاونا دوليا يشمل كل المختصين في هذا المجال، لكنه يشكك في القدرة على تحقيق ذلك قائلا: “قد يكون الأمر مستحيلا.. فلا توجد طريقة لمعرفة ما إذا كانت الشركات أو الدول تعمل على مثل هذه البرامج سرا، والأمل الوحيد هو أن يعمل أهم العلماء في العالم يدا بيد لإيجاد حلول للتحكم في الذكاء الاصطناعي”.